在人工智能(AI)大模型时代下,算力扮演着越来越重要的角色,成为关键生产力。

艾瑞咨询发布的《2023年中国智能算力行业发展白皮书》报告显示,2023年大模型算力需求集中爆发,AI 大模型相关行业占中国智能算力总需求的58.8%,接近60%,是智能算力的最大需求方;排名第二的是算法推荐,占比14.2%。

报告还显示,2022年中国算力结构中,智能算力规模占比达22.8%,但同期中国服务器结构中,AI服务器出货量占比仅6.8%。这意味着,智算资源存在稀缺性,而智算中心建设将有效改善中国智算资源供需结构。

艾瑞咨询产业数字化研究院负责人徐樊磊表示,未来,通用人工智能(AGI)技术将不断发展,将推动整体智算需求提升,因此需要拥有足够的高端智能算力和不断优化的软硬件融合解决方案,以及可以构建生态汇聚上下游、全链条、各领域的参与者,并使用门槛足够低和便利。

事实上,过去一年多,以ChatGPT为代表的生成式 AI 技术风靡全球。而作为以95%的市场占有率垄断了全球 Al 训练芯片的英伟达,成为了这轮 AI 混战的最大赢家,其研发的A100/A800、H100/H800等多个 AI 芯片成为 AI 热潮中的“爆品”。

正如英伟达自己所说:“GPU 已经成为人工智能的稀有金属,甚至是黄金,因为它们是当今生成式 AI 时代的基础。”

从技术角度来说,GPU优于CPU(通用处理器),特别是在并行计算能力、能耗效率和CUDA生态等方面,它的高算力和可扩展性使英伟达GPU成为AI加速芯片市场的首选。

根据斯坦福大学最近发布的一项报告显示,自2003年以来,过去20年GPU性能提高了约7000倍,单位性能价格也提高了5600倍。该报告还指出,GPU是推动 AI 技术进步的关键动力。

如今,算力正加速向政务、工业、交通、医疗等各行业应用加速演进,推动互联网、大数据、人工智能等与实体经济深度融合,极大地激发了数据要素创新活力。

什么是GPU(图形处理器)?

GPU是显卡的核心部件,英文全名叫Graphics Processing Unit,图形处理单元(图形处理器)。GPU并不能和显卡划等号。显卡除了GPU之外,还包括显存、VRM稳压模块、MRAM芯片、总线、风扇、外围设备接口等。

1999年,英伟达(NVIDIA)公司率先提出了GPU的概念。之所以要提出GPU,是因为90年代游戏和多媒体业务高速发展。这些业务给计算机的3D图形处理和渲染能力提出了更高的要求。传统CPU搞不定,所以引入了GPU,分担这方面的工作。

根据形态,GPU可分为独立GPU(dGPU,discrete/dedicated GPU)和集成GPU(iGPU,integrated GPU),也就是常说的独显、集显。

GPU也是计算芯片。所以,它和CPU一样,包括了运算器、控制器和寄存器等组件。但是,因为GPU主要负责图形处理任务,所以,它的内部架构和CPU存在很大的不同。

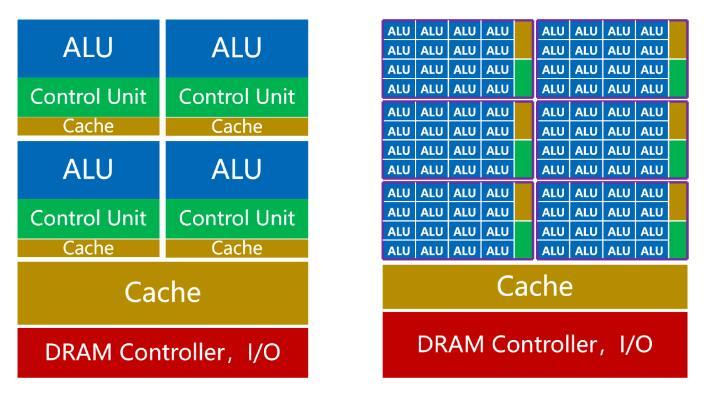

如上图所示,CPU的内核(包括了ALU)数量比较少,最多只有几十个。但是,CPU有大量的缓存(Cache)和复杂的控制器(CU)。

这样设计的原因,是因为CPU是一个通用处理器。作为计算机的主核心,它的任务非常复杂,既要应对不同类型的数据计算,还要响应人机交互。

复杂的条件和分支,还有任务之间的同步协调,会带来大量的分支跳转和中断处理工作。它需要更大的缓存,保存各种任务状态,以降低任务切换时的时延。它也需要更复杂的控制器,进行逻辑控制和调度。

CPU的强项是管理和调度。真正干活的功能,反而不强(ALU占比大约5%——20%)。

如果我们把处理器看成是一个餐厅的话,CPU就像一个拥有几十名高级厨师的全能型餐厅。这个餐厅什么菜系都能做,但是,因为菜系多,所以需要花费大量的时间协调、配菜,上菜的速度相对比较慢。

而GPU则完全不同。GPU为图形处理而生,任务非常明确且单一。它要做的,就是图形渲染。图形是由海量像素点组成的,属于类型高度统一、相互无依赖的大规模数据。所以,GPU的任务,是在最短的时间里,完成大量同质化数据的并行运算。所谓调度和协调的“杂活”,反而很少。

并行计算,当然需要更多的核啊,如前图所示,GPU的内核数,远远超过CPU,可以达到几千个甚至上万个(也因此被称为“众核”)。

GPU的核,称为流式多处理器(Stream Multi-processor,SM),是一个独立的任务处理单元。

在整个GPU中,会划分为多个流式处理区。每个处理区,包含数百个内核。每个内核,相当于一颗简化版的CPU,具备整数运算和浮点运算的功能,以及排队和结果收集功能。

GPU的控制器功能简单,缓存也比较少。它的ALU占比,可以达到80%以上。

虽然GPU单核的处理能力弱于CPU,但是数量庞大,非常适合高强度并行计算。同等晶体管规模条件下,它的算力,反而比CPU更强。

还是以餐厅为例。GPU就像一个拥有成千上万名初级厨师的单一型餐厅。它只适合做某种指定菜系。但是,因为厨师多,配菜简单,所以大家一起炒,上菜速度反而快。

GPU集群:人工智能计算的重型装备

GPU群集,也称为图形处理单元群集,是一个并行计算系统,它利用多个GPU来增强计算功能。这种方法可以通过大规模并行化来加速各种应用和模拟。 GPU群集的组成由几个关键组件组成。首先,GPU本身是集群的核心,是专门为并行计算任务设计的。与用于顺序处理的传统CPU不同,GPU同时执行多个任务,使其成为并行工作负载的理想选择。此外,GPU群集通常合并多个节点,每个节点包含一个或多个GPU,一个CPU,内存,存储和网络功能。这些节点之间的有效沟通和协作对于集群的整体性能至关重要。

CPU充当协调员,管理和协调集群中的任务,尤其是那些不适合并行处理的任务。内存在GPU群集中也起着至关重要的作用,每个GPU在计算过程中都有自己的高速内存(VRAM)用于数据存储。此外,节点还配备了GPU和CPU之间共享的系统内存(RAM),以促进有效的数据传输。为了容纳数据集,应用程序和结果的存储,GPU群集需要大量的存储空间。高性能存储解决方案(例如SSD)通常用于最大程度地减少数据检索时间并确保实现平稳的工作流程。

互连是指节点之间的通信路径,在GPU群集中也至关重要。高速互连技术(例如Infiniband或Nvidia Nvlink)通常用于最大程度地减少延迟并最大化数据传输速率。 GPU群集的利用率扩展到各个字段。科学研究,特别是在物理,化学和生物学方面,从GPU群集的平行处理能力中受益匪浅,启用了诸如分子动力学模拟,天气预测和粒子物理模拟之类的任务。对人工智能和机器学习的需求激增也驱动了GPU群集的采用,因为它们非常适合培训深层神经网络并提高AI应用的效率。在石油和天然气行业中,GPU群集用于诸如需要密集计算的地震数据处理和收集模拟等任务。财务建模,计算机辅助设计和绘图行业还采用GPU集群来加快复杂的数学建模,渲染高质量的图像和视频,并促进更好的决策过程。在医学领域,GPU集群在医学成像,药物发现和基因组学等任务中起着至关重要的作用,加速了大型数据集的分析,并推进了个性化医学和基因组研究。

尽管GPU群集提供了重要的计算能力,但仍然存在诸如功耗,散热和编程复杂性之类的挑战。但是,预计硬件设计,互连技术和软件优化的进步将解决这些挑战并增强GPU群集的能力。最终,GPU群集代表了各种科学,工业和技术领域的平行计算和驱动突破的最前沿,将GPU集成到群集系统中,塑造了高性能计算的前景。

GPU如何成为AI计算的主流?

早在2005年和2006年就有研究采用GPU进行两层的神经网络(NN/CNN)计算,并且对比了GPU和CPU上的性能差异,不过那时在GPU上的加速效果并没有现在这样明显,通常在1-3倍左右,在CPU上采用特定的加速工具也能取得不错的效果,可能正是因为GPU上的加速效果有限,在那个时候GPU并没有成为AI计算的主流,也就是在研究层面做些尝试和探索。

2011年Dan等的研究采用英特尔Core i7-920的CPU,以及英伟达GTX 480和GTX 580的GPU,进行CNN模型的计算,结果显示GPU的加速效果达到了CPU的10-60倍,其中网络规模小的模型加速效果10倍速左右,对于网络规模大的模型加速效果达到60倍。GPU在AI计算中的加速效果已经非常显著,为进一步扩大GPU在AI计算领域应用创造了有利条件。

2012年,Hinton和Alex Krizhevsky设计的AlexNet,使用了两块英伟达GTX 580训练了两周的模型,将计算机图像识别的正确率提升了一个数量级,并获得了2012年ImageNet竞赛冠军,充分展示了GPU在AI计算中的巨大潜力。此前,在谷歌使用1000台CPU服务器,完成了猫脸识别的任务,2012年吴恩达等采用3台GTX680-GPU服务器完成了同样的任务。毋庸置疑,AlexNet和吴恩达等工作在业界和学界都产生了良好的示范效应。或许从这段时间开始,学术界关于AI相关的研究逐渐更多的采用了GPU,互联网头部厂商也陆续开始引入GPU到各自的生产研发环境。

2016年AlphaGo战胜李世石,2017年AlphaGo又战胜柯洁,标志着新一波AI发展热潮的开始,带动了全球AI产业发展。也是在AlphaGo之后,以深度学习为核心的AI技术逐渐在越来越多的应用场景落地,AI领域的创新创业也不断涌现,差不多从这时候开始,GPU基本开始成为AI计算的标配。最近随着AI技术的应用领域不断扩大,对GPU算力需求也是不断增加,目前还呈现出GPU供不应求的局面。

从2005/2006年开始有人尝试用GPU进行AI计算,到2012/2013年GPU被更大范围的接受,以及到2016/2017年GPU成本AI计算的标配,具有一定的偶然性,发现深度学习网络层次越深、网络规模越大,GPU的加速效果越显著。然而这又注定会是个必然的结果,AI经历三起三落的发展,每一次“落”的过程都为下一次“起”积蓄能量,第三“落”似乎算力不足是重要的因素,GPU的工作原理正好很大程度上契合了AI计算的需求,GPU算力的不断提升,以及2016年英伟达新的GPU架构专门针对AI计算场景进行优化和支持,对更多的AI计算场景采纳GPU都有重要推动作用。